機器之心 & ArXiv Weekly Radiostation

參與:杜偉、楚航、羅若天

本週的重要論文包括來自微軟 Cloud+AI 部門的 DeepDebug,一種使用大型預訓練模型 transformer 進行自動除錯的方法;UC 伯克利等機構提出的 APPS(Automated Programming Progress Standard),一個程式碼生成基準,該基準測試能夠衡量模型的程式碼生成能力,並檢查程式碼是否符合問題要求等研究。

目錄:

DeepDebug: Fixing Python Bugs Using Stack Traces, Backtranslation, and Code Skeletons

Measuring Coding Challenge Competence With APPS

DeepViT: Towards Deeper Vision Transformer

ChoreoMaster: Choreography-Oriented Music-Driven Dance Synthesis

One-Shot Voice Conversion Based on Speaker Aware Module

UNIMO: Towards Unified-Modal Understanding and Generation via Cross-Modal Contrastive Learning

ERNIE-Doc: A Retrospective Long-Document Modeling Transformer

ArXiv Weekly Radiostation:NLP、CV、ML 更多精選論文(附音訊)

論文 1:DeepDebug: Fixing Python Bugs Using Stack Traces, Backtranslation, and Code Skeletons

作者:Dawn Drain、Colin B。 Clement、Guillermo Serrato、Neel Sundaresan

連結:https://arxiv。org/pdf/2105。09352。pdf

摘要:

本地化 Bug 並修復程式是軟體開發過程中的重要任務。在本篇論文中,來自微軟 Cloud+AI 部門的研究者介紹了 DeepDebug,一種使用大型預訓練模型 transformer 進行自動除錯的方法。研究者基於 20 萬個庫中的函式訓練了反向翻譯模型。接下來,他們將注意力轉向可以對其執行測試的 1 萬個庫,並在這些已經透過測試的庫中建立所有函式的 bug 版本。這些豐富的除錯資訊,例如棧追蹤和列印語句,可以用於微調已在原始原始碼上預訓練的模型。最後,研究者透過將上下文視窗擴充套件到 bug 函式本身外,並按優先順序順序新增一個由該函式的父類、匯入、簽名、文件字串、方法主體組成的框架,從而增強了所有模型。

在 QuixBugs 基準上,研究者將 bug 的修補總數增加了 50%以上,同時將誤報率從 35%降至 5%,並將超時從 6 小時減少到 1 分鐘。根據微軟自己的可執行測試基準,此模型在不使用跟蹤的情況下首次修復了 68%的 bug;而在新增跟蹤之後,第一次嘗試即可修復 75%的錯誤。

訓練 pipeline。

推薦:

bug 的修補總數增加了 50%以上,誤報率從 35%降至 5%,超時從 6 小時減少到 1 分鐘。

論文 2:Measuring Coding Challenge Competence With APPS

作者:Dan Hendrycks、Steven Basart、Saurav Kadavath、Mantas Mazeika、Akul Arora、Ethan Guo、Collin Burns、Samir Puranik、Horace He、Dawn Song、Jacob Steinhardt

連結:https://arxiv。org/pdf/2105。09938。pdf

摘要:

隨著深度學習的興起,AI 讓許多行業實現了自動化,包括將 AI 用於程式設計。人們在程式設計時通常會使用大量的有意識和潛意識思維機制發現新問題並探索不同的解決方案,然而大多數機器學習演算法都需要定義明確的問題和大量帶有註釋的資料才能夠開發出解決相同程式設計問題的模型,因此用 AI 程式設計並非易事。此外,準確地評估模型的程式碼生成效能可能是很困難的,並且很少有既靈活又嚴格的方式來評估程式碼生成的研究。

基於此,來自 UC 伯克利等機構的研究者提出了 APPS(Automated Programming Progress Standard),一個程式碼生成基準,該基準測試能夠衡量模型的程式碼生成能力,並檢查程式碼是否符合問題要求。與公司評估候選軟體開發人員的方式類似,該研究透過檢查生成的程式碼在測試用例上的結果來評估模型。基準測試包括 10,000 個問題,包含單行程式碼解決的簡單問題和具有大量程式碼的複雜演算法挑戰等多多種問題。上述 AI 生成程式碼示例在 APPS 資料集中被視為「面試級別」的問題。

AI 的解答程式碼。

推薦:

程式設計師終究捲到了自家?

論文 3:DeepViT: Towards Deeper Vision Transformer

作者:Daquan Zhou、Bingyi Kang、Xiaojie Jin、Linjie Yang、Xiaochen Lian、Zihang Jiang、Qibin Hou、Jiashi Feng

連結:https://arxiv。org/pdf/2103。11886。pdf

摘要:

視覺 transformer (ViT) 現已成功地應用於影象分類任務。近日,來自新加坡國立大學和位元組跳動美國 AI Lab 的研究者表明,不同於卷積神經網路透過堆疊更多的卷積層來提高效能,ViT 的效能在擴充套件至更深時會迅速飽和。具體而言,研究者根據經驗觀察到,這種擴充套件困難是由注意力崩潰(attention collapse)引起的:隨著 Transformer 加深,注意力圖在某些層之後逐漸變得相似甚至幾乎相同。換句話說,在 deep ViT 模型的頂層中,特徵圖趨於相同。這一事實表明,在更深層的 ViT 中,自注意力機制無法學習有效的表徵學習概念,並且阻礙了模型獲得預期的效能提升。

基於以上觀察,研究者提出了一種簡單而有效的方法 Re-attention,它可以忽略計算和儲存成本重新生成注意力圖以增加其在不同層的多樣性。藉助於該方法,我們可以透過對現有 ViT 模型的微小修改來訓練具有持續效能改進的更深的 ViT 模型。此外,當使用 32 個 transformer 塊訓練 DeepViT 模型時,在 ImageNet 資料集上實現了頗具競爭力的 Top-1 影象分類準確率。相較於 ViT-32B, 變體模型 DeepViT-32B 的 Top-1 準確率提升了 1。6%。

具有 N 個 transformer 塊的原版 ViT 模型與該研究所提 DeepViT 模型的結構對比。

推薦:

相較於 ViT-32B, 變體模型 DeepViT-32B 的 Top-1 影象分類準確率提升了 1。6%。

論文 4:ChoreoMaster: Choreography-Oriented Music-Driven Dance Synthesis

作者:Kang Chen、Zhipeng Tan、Jin Lei、Song-Hai Zhang、Yuan-Chen Guo、Weidong Zhang、Shi-Min Hu

連結:https://netease-gameai。github。io/ChoreoMaster/Paper。pdf

摘要:

舞蹈動畫在遊戲和影視行業已非常普遍,目前業內製作舞蹈動畫大多采用的是手 K 或動捕,生產一段高質量的舞蹈動畫依然需要耗費大量的時間和精力。因此 AI 合成舞蹈成為時下熱門的研究課題。但舞蹈作為一種獨立的藝術形式,其動作與配樂在風格、節奏和結構等方面無一不透露出編舞學的專業知識,想要穩定輸出高質量的結果並非易事。儘管業界也曾出現過多項紅極一時的研究成果,如 AI Choreographer 和 DanceNet3D,然而這些方案並未落地於實際商業生產應用。

歷經兩年多的潛心研發,網易互娛 AI LAB 的研發團隊提出了符合實際生產環境應用要求的 AI 舞蹈動畫合成方案 ChoreoMaster。該方案的亮點在於:除了能夠快速穩定地輸出一段符合編舞美學、符合多種舞種風格、連貫自然的舞蹈動畫以外,還靈活支援豐富的約束方式來指導演算法按照使用者期望的方向合成舞蹈動畫,如可替換或刪除指定片段、預設舞蹈軌跡和限制舞蹈範圍等。

ChoreoMaster 的技術方案。

推薦:

全球首個落地的舞蹈動畫合成系統,入選 SIGGRAPH 2021。

論文 5:One-Shot Voice Conversion Based on Speaker Aware Module

作者:Ying Zhang、Hao Che、Jie Li、Chenxing Li、Xiaorui Wang、Zhongyuan Wang

連結:https://ieeexplore。ieee。org/stamp/stamp。jsp?tp=&arnumber=9414081

摘要:

語音轉換(VC)是指在保證一句話內容不變的基礎上,將原始語音中說話人音色遷移到目標說話人音色。語音轉換在電影配音、角色模仿以及復刻人物音色等方面都有重要的應用。當前基於深度學習實現到特定目標說話人的語音轉換已經取得很大的進步,例如基於 CycleGAN、VAE 以及 ASR 的語音轉換方法都可以很好的實現到訓練集內說話人的語音轉換。然而,如果想要增加一個目標說話人音色,或者進行使用者音色的自定義復刻,通常需要大量的說話人資料以重新訓練一個以該說話人音色為目標音色語音轉換模型,或者透過少量資料對現有模型進行自適應訓練。實際應用中,資料庫錄製的週期和成本都比較高,而對於普通使用者而言,也很難獲得使用者大量的語音資料。因此,小資料的語音轉換成為亟待解決的熱點問題。而來自快手負責音訊技術研發部門 MMU 的研發人員提出了一種基於說話人感知模組(SAM)的單樣本語音轉換的解決方案。該方案僅透過說話人的單句語音樣本提取使用者的音色表徵,就可以實現該說話人作為目標說話人音色的語音轉換。

說話人感知語音轉換(SAVC)系統架構。

推薦:

一句話複製你的音色,已被 ICASSP 2021 接收。

論文 6:UNIMO: Towards Unified-Modal Understanding and Generation via Cross-Modal Contrastive Learning

作者:Wei Li、Can Gao、Guocheng Niu、Xinyan Xiao、Hao Liu、Jiachen Liu、Hua Wu、Haifeng Wang

連結:https://arxiv。org/abs/2012。15409

摘要:

大資料是深度學習取得成功的關鍵基礎之一。當前的預訓練方法,通常分別在各種不同模態資料上分別進行,難以同時支援各類語言和影象的任務。基於深度學習的 AI 系統是否也能像人一樣同時學習各種單模、多模等異構模態資料呢?如果能夠實現,無疑將進一步開啟深度學習對大規模資料利用的邊界,從而進一步提升 AI 系統的感知與認知的通用能力。

為此,語言與視覺一體的模型 ERNIE-UNIMO 提出統一模態學習方法,同時使用單模文字、單模影象和多模圖文對資料進行訓練,學習文字和影象的統一語義表示,從而具備同時處理多種單模態和跨模態下游任務的能力。此方法的核心模組是一個 Transformer 網路,在具體訓練過程中,文字、影象和圖文對三種模態資料隨機混合在一起,其中影象被轉換為目標(object)序列,文字被轉換為詞(token)序列,圖文對被轉換為目標序列和詞序列的拼接。統一模態學習對三種類型資料進行統一處理,在目標序列或者詞序列上基於掩碼預測進行自監督學習,並且基於圖文對資料進行跨模態對比學習,從而實現影象與文字的統一表示學習。進一步的,這種聯合學習方法也讓文字知識和視覺知識互相增強,從而有效提升文字語義表示和視覺語義表示的能力。此方法在語言理解與生成、多模理解與生成,4 類場景、共 13 個任務上超越主流的文字預訓練模型和多模預訓練模型,同時登頂權威視覺問答榜單 VQA、文字推理榜單 aNLI。

UNIMO 學習架構。

推薦:

首次驗證了透過非平行的文字與影象單模資料,能夠讓語言知識與視覺知識相互增強。

論文 7:ERNIE-Doc: A Retrospective Long-Document Modeling Transformer

作者:Siyu Ding、Junyuan Shang、Shuohuan Wang、Yu Sun、Hao Tian、Hua Wu、Haifeng Wang

連結:https://arxiv。org/abs/2012。15688

摘要:

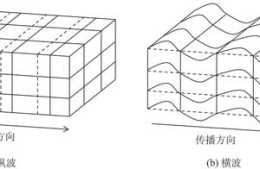

Transformer 是 ERNIE 預訓練模型所依賴的基礎網路結構,但由於其計算量和空間消耗隨建模長度呈平方級增加,導致模型難以建模篇章、書籍等長文字內容。受到人類先粗讀後精讀的閱讀方式啟發,ERNIE-Doc 首創回顧式建模技術,突破了 Transformer 在文字長度上的建模瓶頸,實現了任意長文字的雙向建模。透過將長文字重複輸入模型兩次,ERNIE-Doc 在粗讀階段學習並存儲全篇章語義資訊,在精讀階段針對每一個文字片段顯式地融合全篇章語義資訊,從而實現雙向建模,避免了上下文碎片化的問題。此外,傳統長文字模型(Transformer-XL 等)中 Recurrence Memory 結構的迴圈方式限制了模型的有效建模長度。ERNIE-Doc 將其改進為同層迴圈,使模型保留了更上層的語義資訊,具備了超長文字的建模能力。

ERNIE-Doc 顯著提升了長文字的建模能力,可以解決很多傳統模型無法處理的應用難題。例如在搜尋引擎中,ERNIE-Doc 可以對網頁整體理解,返回使用者更加系統的結果。在智慧創作中,ERNIE-Doc 可以用來生成更加長篇、語義豐富的文章。超長文字理解模型 ERNIE-Doc 在包括閱讀理解、資訊抽取、篇章分類、語言模型等不同型別的 13 個典型中英文長文字任務上取得最優的效果。

ERNIE-Doc 中的回顧式建模與增強記憶機制。

篇章重排序學習。

推薦:

實現雙向建模,顯著提升了長文字的建模能力。

ArXiv Weekly Radiostation

機器之心聯合由楚航、羅若天發起的ArXiv Weekly Radiostation,在 7 Papers 的基礎上,精選本週更多重要論文,包括NLP、CV、ML領域各10篇精選,並提供音訊形式的論文摘要簡介,詳情如下:

本週 10 篇 NLP 精選論文是:

1。 Extending rational models of communication from beliefs to actions。 (from Thomas L。 Griffiths)

2。 True Few-Shot Learning with Language Models。 (from Kyunghyun Cho)

3。 Measuring Fine-Grained Domain Relevance of Terms: A Hierarchical Core-Fringe Approach。 (from Kevin Chen-Chuan Chang, Wen-mei Hwu)

4。 Neural Machine Translation with Monolingual Translation Memory。 (from Deng Cai)

5。 Dynamic Semantic Graph Construction and Reasoning for Explainable Multi-hop Science Question Answering。 (from Deng Cai)

6。 Prosodic segmentation for parsing spoken dialogue。 (from Mark Steedman)

7。 Retrieval Enhanced Model for Commonsense Generation。 (from Yang Liu)

8。 Distantly-Supervised Long-Tailed Relation Extraction Using Constraint Graphs。 (from Yang Liu)

9。 Unsupervised Sentiment Analysis by Transferring Multi-source Knowledge。 (from Jian Liu)

10。 Focus Attention: Promoting Faithfulness and Diversity in Summarization。 (from Ryan McDonald)

本週 10 篇 CV 精選論文是:

1。 ADNet: Attention-guided Deformable Convolutional Network for High Dynamic Range Imaging。 (from Jian Sun)

2。 PSGAN++: Robust Detail-Preserving Makeup Transfer and Removal。 (from Shuicheng Yan)

3。 Human-centric Relation Segmentation: Dataset and Solution。 (from Shuicheng Yan)

4。 PLM: Partial Label Masking for Imbalanced Multi-label Classification。 (from Mubarak Shah)

5。 Intriguing Properties of Vision Transformers。 (from Ming-Hsuan Yang)

6。 Unsupervised Part Segmentation through Disentangling Appearance and Shape。 (from Lei Zhang)

7。 Recent Standard Development Activities on Video Coding for Machines。 (from Wen Gao)

8。 ViPNAS: Efficient Video Pose Estimation via Neural Architecture Search。 (from Xiaogang Wang)

9。 WSSOD: A New Pipeline for Weakly- and Semi-Supervised Object Detection。 (from Kai Chen)

10。 Few-Shot Learning with Part Discovery and Augmentation from Unlabeled Images。 (from Liang Wang, Tieniu Tan)

本週 10 篇 ML 精選論文是:

1。 Comment on Stochastic Polyak Step-Size: Performance of ALI-G。 (from Andrew Zisserman)

2。 DiBS: Differentiable Bayesian Structure Learning。 (from Bernhard Sch lkopf, Andreas Krause)

3。 A Robust and Generalized Framework for Adversarial Graph Embedding。 (from Philip S。 Yu)

4。 Anomaly Detection in Predictive Maintenance: A New Evaluation Framework for Temporal Unsupervised Anomaly Detection Algorithms。 (from Francisco Herrera)

5。 Robust Value Iteration for Continuous Control Tasks。 (from Shie Mannor, Jan Peters, Dieter Fox)

6。 A Precise Performance Analysis of Support Vector Regression。 (from Mohamed-Slim Alouini)

7。 Trimming Feature Extraction and Inference for MCU-based Edge NILM: a Systematic Approach。 (from Luca Benini)

8。 ReduNet: A White-box Deep Network from the Principle of Maximizing Rate Reduction。 (from John Wright)

9。 Causally Constrained Data Synthesis for Private Data Release。 (from Somesh Jha)

10。 Robust learning from corrupted EEG with dynamic spatial filtering。 (from Alexandre Gramfort)

THE END

轉載請聯絡本公眾號獲得授權